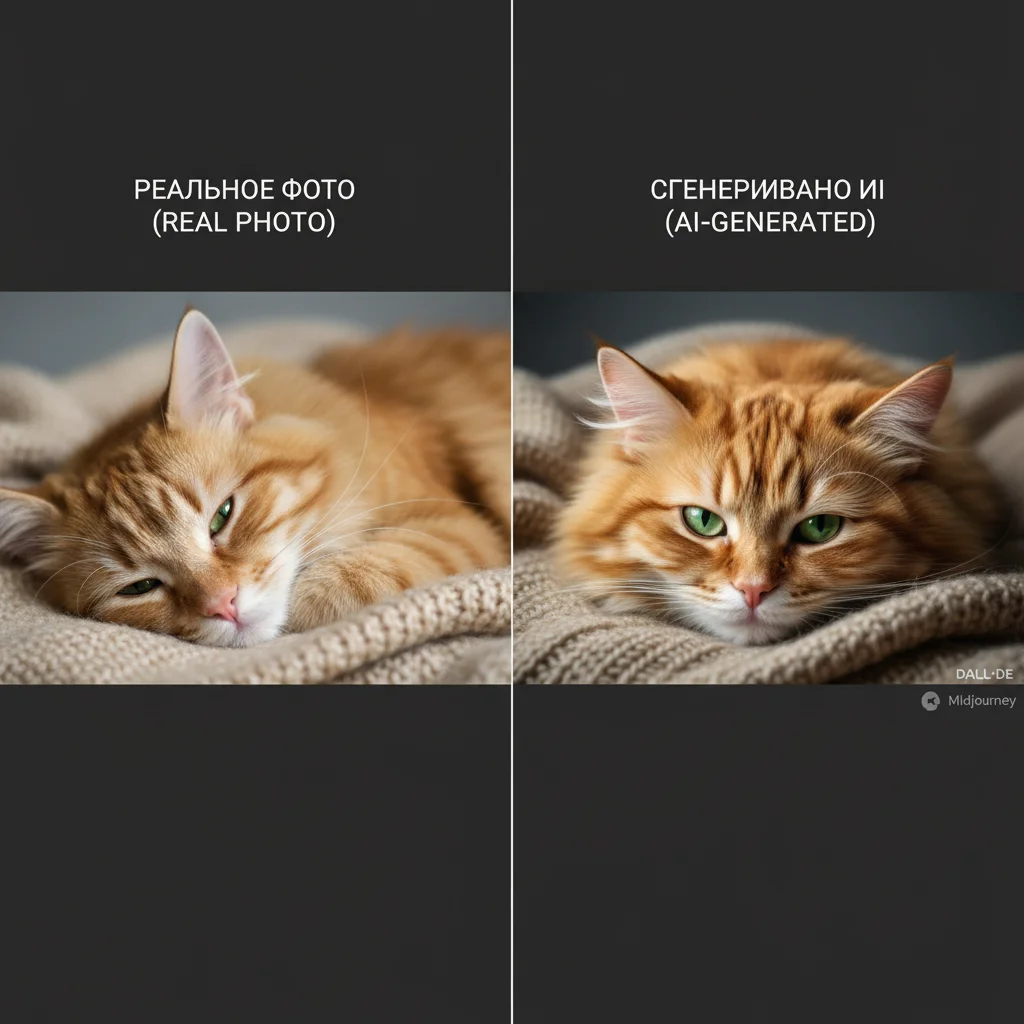

Когда нейросеть отвечает на вопрос или пишет эссе, создаётся впечатление, что она «понимает». Но на самом деле она не обладает сознанием, опытом или намерением. Её «понимание» — это статистическое предсказание на основе огромного опыта чтения.

Как это работает:

Контекстное предсказание

Основная задача языковой модели — предсказать следующее слово в последовательности. Например, после «Небо было...» модель знает, что чаще всего идёт «голубым», «пасмурным» или «ярким».Моделирование отношений

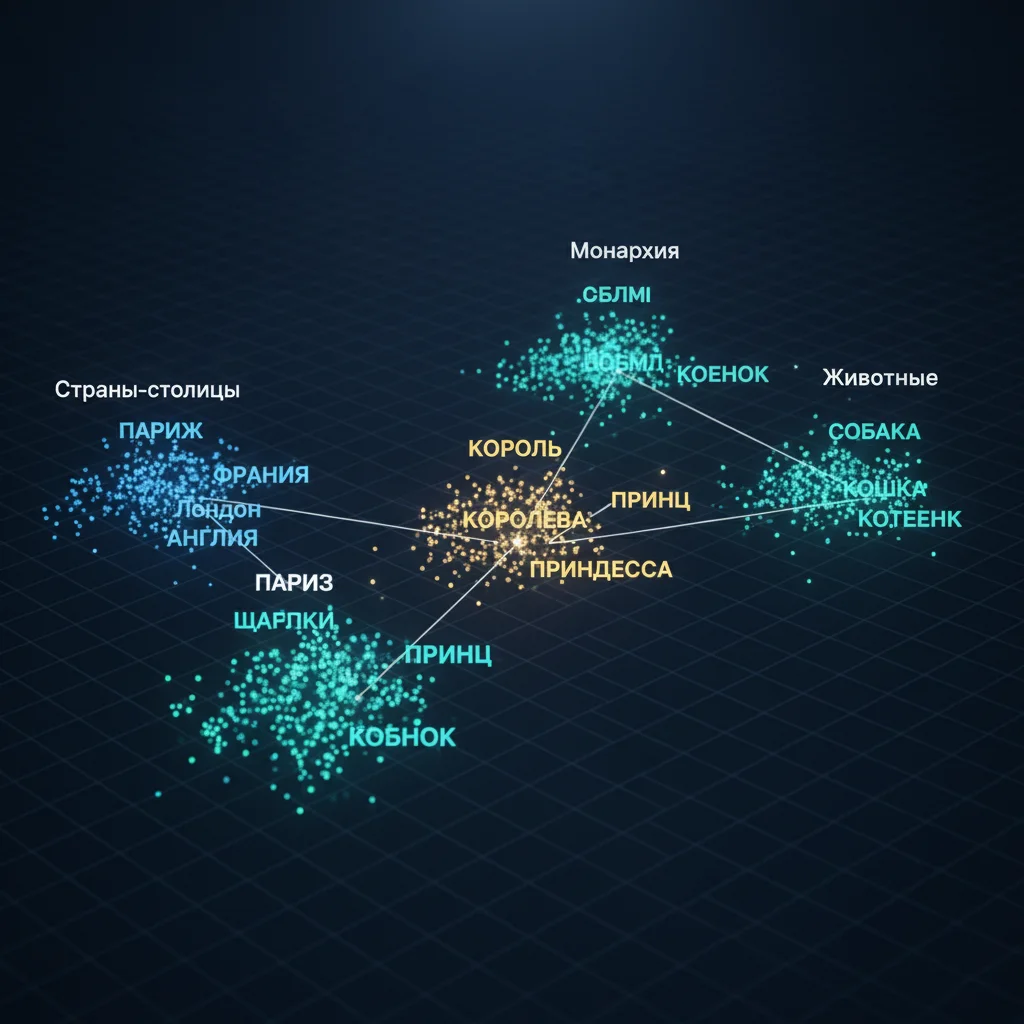

Благодаря embedding и attention, сеть улавливает:- Синонимы и антонимы,

- Причинно-следственные связи («дождь → мокрый»),

- Эмоциональную окраску («радость» vs «печаль»).

Имитация рассуждений

При запросе вроде «Объясни теорию относительности» сеть не «вспоминает», а генерирует правдоподобный текст, основанный на миллионах примеров объяснений из обучающих данных.

Что нейросеть НЕ умеет:

- Понимать физическую реальность (она не знает, что такое «боль» или «апельсин» на вкус),

- Иметь цель или намерение,

- Отличать правду от вымысла без внешней проверки.

Почему это всё равно работает:

Потому что язык сам по себе — структурированная система. Даже без понимания мира, можно научиться его «звучанию».

Таким образом, нейросеть «понимает» язык так же, как отличный имитатор может говорить на языке, не зная культуры. Это не сознание — но это невероятно мощная имитация смысла, достаточная для общения, творчества и помощи.