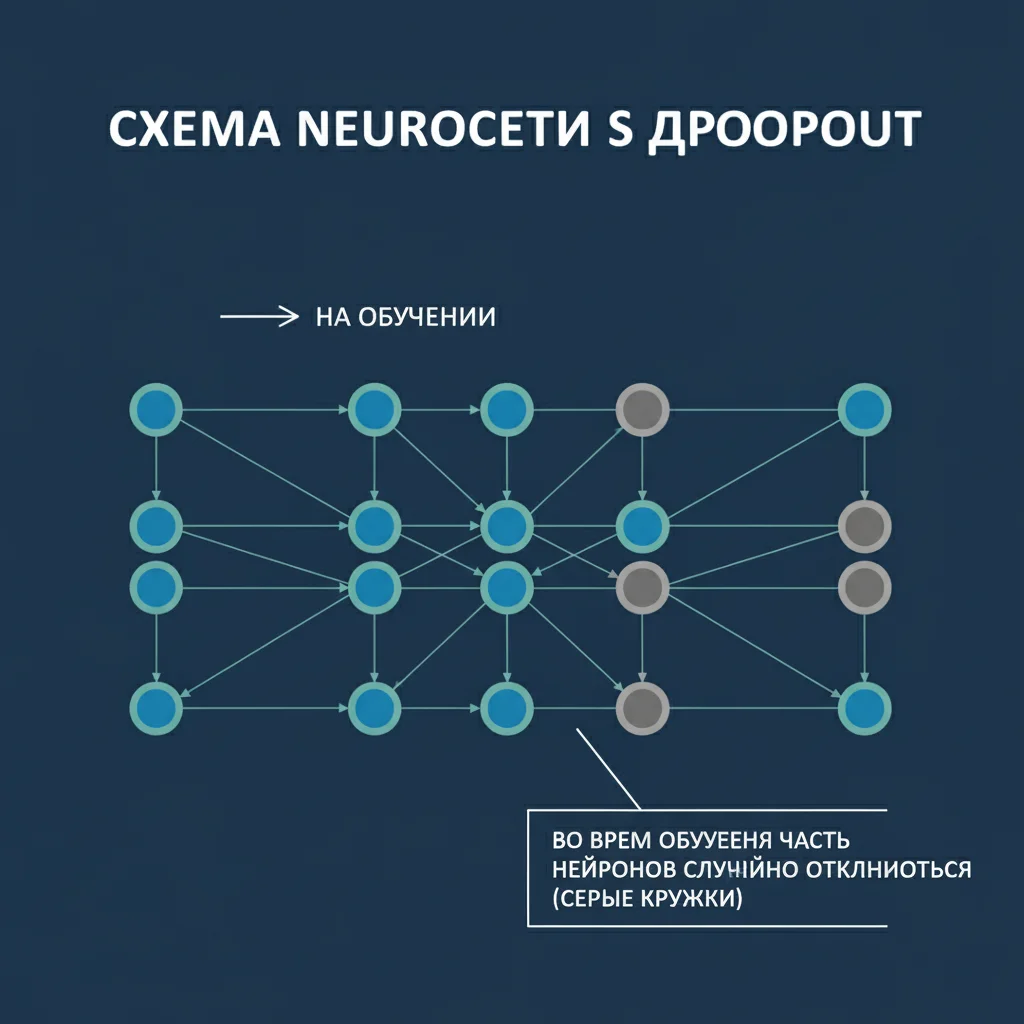

Dropout — это регуляризационная техника, используемая во время обучения нейросети для предотвращения переобучения. Суть проста: случайным образом «отключаются» нейроны в скрытых слоях на каждом шаге обучения.

Как это работает:

- На каждом проходе (батче) сеть «теряет» часть нейронов (например, 50%),

- Оставшиеся нейроны вынуждены работать самостоятельно, не полагаясь на конкретных «звёзд» в сети,

- После обучения все нейроны включаются, но их веса корректируются с учётом «опыта работы в одиночку».

Почему это эффективно:

Предотвращает переобучение

Сеть не запоминает обучающие данные, а учится обобщать, потому что не может полагаться на одни и те же связи.Создаёт «ансамбль моделей»

Фактически, dropout заставляет сеть обучаться как множество разных подсетей, что повышает устойчивость.

- Упрощает архитектуру

Благодаря dropout можно использовать более крупные сети без риска переобучения.

Аналогия:

Представьте команду, где каждый день кто-то болеет. Чтобы проект не останавливался, все учатся делать работу коллег. В итоге команда становится гибкой и надёжной — даже если кто-то уйдёт, работа продолжится.

Dropout — это не ошибка, а умышленная слабость, которая делает модель сильнее. Именно такие «умные ограничения» позволяют ИИ работать не только на тренировочных данных, но и в реальном мире.